Wstęp

To znów ten czas. Za oknami powoli zaczyna się jesień, rozpoczął się kolejny rok szkolny, a firma Apple przygotowuje się do wypuszczenia nowego sprzętu i oprogramowania. Jeśli jesteście ciekawi, co się zmieniło w sferze dostępności w nowych systemach Apple, to trafiliście w dobre miejsce. W poniższym artykule przedstawię wszystkie nowe oraz zmienione funkcje dostępności w systemach iOS 17, Mac OS 14 Sonoma oraz watchOS 10 z naciskiem na osoby z dysfunkcją wzroku.

iOS 17

iOS 17 to głównie dużo nowości wizualnych. Od personalizowanych wizytówek, które zobaczą inni, kiedy do nich dzwonimy, możliwości wstawiania naklejek wszędzie tam, gdzie wpisujemy tekst, po tryb Standby, który może ciągle wyświetlać różne informacje, kiedy nasz telefon się ładuje. To oczywiście nie wszystko, bo dostajemy również interaktywne widgety, profile w Safari, łatwe udostępnianie innym naszego kontaktu poprzez zbliżenie telefonu i wiele więcej. No i nie mogę zapomnieć o nowych dzwonkach!

W sferze dostępności siedemnasta wersja iOS przyniosła całkiem sporo nowych funkcji. Większość z nich nie została stworzona z myślą o osobach z dysfunkcją wzroku, co jednakże nie oznacza, że funkcje te nam się nie przydadzą. Nie oznacza to również, że VoiceOver stoi w miejscu, bo i tutaj Apple dodało kilka nowości i właśnie od nich zaczniemy.

Dodatkowe opcje dla syntezatorów mowy

Na dowolnej liście głosów (NP. Podczas dodawania języka do pokrętła) dla każdego z pobranych głosów pojawiła się nowa czynność – “Otwórz poszczególne ustawienia głosu”. Dostępne opcje w tym oknie będą zależeć od syntezatora. W przypadku Vocalizera odpowiedzialnego za polskie głosy wbudowane w system możemy ustawić barwę głosu oraz długość przerw między zdaniami. Zwłaszcza ta druga opcja może być bardzo przydatna dla tych, którzy lubią słuchać syntezy z dużą prędkością. Potencjał tego nowego rozwiązania pokazują nam opcje zaoferowane w syntezatorze Eloquence. Tutaj możemy dodatkowo ustawić parametry, takie jak wyłączenie słownika skrótów, głębokość intonacji, częstotliwość próbkowania lub włączyć dodatkowy słownik redagowany przez użytkowników. Mam nadzieje, że w przyszłości w głosach Vocalizer również dostaniemy możliwość wyłączenia wszystkich słowników, która byłaby mile widziana przez wiele osób.

Nowości w Brajlu

Użytkownicy monitorów brajlowskich znajdą w iOS 17 kilka przydatnych nowości. Sztandarową nowością jest wcześniej wspomniana kurtyna dźwiękowa, która jak można się domyślić z nazwy, wycisza cały dźwięk i haptyke na urządzeniu, jeśli podłączymy do niego monitor brajlowski. Kiedy pierwszy raz włączymy te opcje, dostaniemy komunikat opisujący, jak działa kurtyna dźwiękowa. Jeśli jest włączona, a do telefonu podłączymy monitor brajlowski, to cały dźwięk (w tym mowa VoiceOvera i dźwięki innych aplikacji) oraz wibracje, są wyłączane. Kiedy odłączymy monitor, to dźwięki automatycznie powrócą. Do przełączania kurtyny dźwiękowej możemy również przypisać gest lub skrót oraz ustawić ją z ekranu szybkich ustawień.

Oprócz kurtyny, w ustawieniach brajla pojawiły się dwie nowe opcje. Pierwszą z nich jest przełącznik “Włączaj Bluetooth po uruchomieniu,”, który automatycznie będzie włączać Bluetooth po starcie VoiceOvera. Drugą opcję znajdziemy klikając w czynność “Więcej opcji” na liście sparowanych monitorów brajlowskich. Jest to przełącznik “Rozłącz po uśpieniu”, który decyduje czy VoiceOver ma pozostać połączony z monitorem, kiedy ekran jest zablokowany. Chociaż może to spowodować większe zużycie baterii, to opcja może być bardzo przydatna dla osób intensywnie korzystających z brajla z dwóch powodów. Po pierwsze, jeśli jakieś powiadomienie obudzi ekran, to monitor zacznie natychmiast reagować i będziemy mogli je przeczytać. Po drugie, będziemy w stanie obudzić nasz telefon z poziomu linijki, nawet jeśli nie symuluje ona klawiatury Bluetooth.

Ostatnią nowością w obsłudze monitorów brajlowskich jest skrót pozwalający na szybkie otwieranie aplikacji. Kiedy jesteśmy na ekranie początkowym, możemy nacisnąć Enter (Spacja+Punkt 8), a następnie wpisać nazwę aplikacji, którą chcemy otworzyć. Podczas pisania VoiceOver będzie wyświetlać nam listę wyników, po której możemy się poruszać przyciskami przewijania lub skrótami Spacja+punkt 4/1. Wybór zatwierdzamy przez ponowne naciśnięcie Entera.

Nowości w czytaniu powiadomień

Wchodząc do ustawień VoiceOver>Szczegółowość>Powiadomienia Systemowe znajdziemy nowe opcje pozwalające nam zdecydować jak VoiceOver ma czytać powiadomienia zarówno na zablokowanym, jak i odblokowanym ekranie.

Dla powiadomień wyświetlanych na ekranie blokady możemy ustalić, czy VoiceOver ma je odczytać, wyświetlić w brajlu, powiedzieć ich liczbę lub nic nie mówić. Niestety, kiedy obudzimy telefon z powiadomieniami na ekranie blokady a VoiceOver jest ustawiony na czytanie liczby lub treści powiadomień, to nie będziemy już słyszeć godziny i musimy ją odczytać ręcznie. Mam nadzieje, że w przyszłości albo będzie to konfigurowalne lub po prostu będziemy znów słyszeć czas oprócz liczby powiadomień jak dotychczas.

Natomiast dla banerów (czyli powiadomień wyświetlanych na górze ekranu, gdy telefon jest odblokowany) możemy zdecydować, czy mają być odczytane, wyświetlane w brajlu lub ogłaszane delikatną haptyką. Dodatkowo możemy również zdecydować, czy VoiceOver ma odczytywać powiadomienia, kiedy telefon jest wyciszony przełącznikiem. Ta ostatnia opcja jest bardzo mile widziana i pozwala nam łatwo wyciszyć czytanie powiadomień, kiedy tego nie chcemy. Jest to o tyle istotne, że kiedy teraz każemy VoiceOverowi czytać dłuższy tekst (NP. Stronę internetową) i przyjdzie jakieś powiadomienie, to czytanie jest teraz przerywane i słyszymy to powiadomienie. W starszych wersjach systemu przychodzące powiadomienia podczas ciągłego czytania nie były automatycznie czytane, ale pozostawały na górze ekranu tak, abyśmy mogli się z nimi zapoznać później.

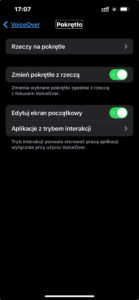

Nowości na pokrętle

Ustawienia pokrętła zostały lepiej uporządkowane i wszystkie są teraz dostępne pod jednym przyciskiem. Pojawiło się również jedno nowe przydatne ustawienie – “Zmieniaj pokrętło z rzeczą”. Pozwala nam zdecydować, czy VoiceOver ma automatycznie przestawiać pokrętło, kiedy ustawimy się na kontrolce, która NP. Oferuje czynności. Załóżmy, że przeglądamy internet i ustawiliśmy pokrętło na nawigacji po nagłówkach, i podczas czytania ustawiliśmy fokus na obrazku. Jeśli teraz spróbujemy nawigować pokrętłem, to zamiast skakania po nagłówkach wybierzemy czynność “eksploruj obraz”. Jeśli wyłączymy to nowe ustawienie, to pokrętło zawsze będzie ustawione na nagłówki, chyba że sami je przestawimy.

Nowości w pisaniu

W iOS 17 Apple zaktualizowało silnik odpowiedzialny za auto korektę na klawiaturze ekranowej. W niektórych językach NP. Angielskim jest on nawet w stanie oferować nam całe zdania. Chociaż w Polskim nie jest on tak inteligentny, to i tak dostaliśmy kilka nowości, na które Polacy czekali bardzo długo. Są to sugestie wyrazów wyświetlane nad klawiaturą oraz możliwość pisania poprzez TZW. Rysowanie ścieżki, które pozwala nam pisać całe wyrazy, przesuwając palec od litery do litery bez odrywania go z ekranu. Nawet jeśli nie planujemy z tego korzystać, to efektem ubocznym wprowadzenia tej funkcji jest ułatwienie wprowadzenia polskich Diakrytyków z klawiatury ekranowej. Od teraz to, jak szybko zobaczymy alternatywne znaki jest kontrolowane przez ustawienie “Czas interakcji klawiatury” w sekcji ustawienia VoiceOver>Wpisywanie.

Kolejną nowością w pisaniu są ustawienia pozwalające nam zdecydować jak VoiceOver ma informować nas o pojawiających się sugestiach auto korekty. Znajdziemy je w ustawieniach szczegółowości i możemy zdecydować, jak mamy być informowani o sugestiach, kiedy się pojawią oraz zostaną zaakceptowane. VoiceOver może je przeczytać normalnie lub innym tonem, albo wyświetlić w brajlu. Możemy również włączyć lub wyłączyć dźwięki.

Zmiany w haptyce i dźwiękach

Skoro o dźwiękach mowa, to i tutaj doszło do kilku zmian. Od teraz mamy sygnały haptyczne, kiedy zmienia się zawartość ekranu, gdy ekran jest zablokowany oraz kiedy kursor VoiceOver przechodzi do następnego lub poprzedniego wiersza. Dźwięk, który słyszymy podczas ładowania stron internetowych, został zmieniony i jest teraz znacznie cichszy.

Wskaż i mów

Od momentu wprowadzenia do systemu iOS aplikacji lupa, każda aktualizacja systemu wprowadzała do niej nowe funkcje, zwłaszcza dla urządzeń wyposażonych w czujnik LIDAR. Nie inaczej jest tym razem. W iOS 17 aplikacja została wzbogacona o dwa nowe tryby.

Pierwszym z nich jest wykrywanie tekstu, które działa podobnie jak funkcje natychmiastowego czytania w aplikacjach typu Seeing AI czy Envision. Kiedy skierujemy aparat na tekst, telefon go nam odczyta. W praktyce, rozwiązania oferowane przez wyżej wspomniane aplikacje działają dużo lepiej. Wykrywanie tekstu w aplikacji lupa nie wspiera języka polskiego, więc wyniki będą pozbawione polskich znaków i słabo odczytywane, chociaż nawet wyniki we wspieranych językach nie powalają z nóg. Aplikacja lupa często ucina wiersze czytanego tekstu i reaguje bardzo wolno w porównaniu do konkurencji. Kilka razy podczas testowania otrzymywałem komunikat, że tekst jest do góry nogami mimo to, że pozostałe aplikacje nie miały z nim problemu, a telefon trzymałem w taki sposób, że tekst był optycznie zorientowany prawidłowo.

Drugi tryb jest o wiele bardziej interesujący. Kiedy firma Apple zapowiedziała go podczas Światowego Dnia Świadomości Dostępności, społeczność się nim bardzo podekscytowała. Tryb “Wskaż i mów”, bo o nim mowa ma za zadanie ułatwić osobom niewidomym dostęp do urządzeń z ekranami dotykowymi. Używając czujnika LIDAR, telefon wykrywa nasz palec, a następnie odczytuje tekst znajdujący się pod nim. Teoretycznie omawiana funkcja ma osobie niewidomej dać możliwość obsłużenia urządzeń z ekranami dotykowymi takich jak ekspresy czy mikrofalówki w sposób podobny do tego, który znamy z obsługi naszego iPhone’a — lekko przesuwając palec nad ekranem, słyszymy dostępne opcje i dzięki temu możemy wybrać te, która nas interesuje.

W praktyce ponownie nie jest tak dobrze, jak sugerowały materiały prasowe. Próby wskazywania tekstu na ekranie komputera wyszły bardzo dobrze i faktycznie byłem w stanie odczytywać tekst, przesuwając palec nad ekranem. Potem przyszedł czas na trudniejsze próby rozpoznawania tekstu na ekranie ekspresu do kawy oraz identycznie wyglądających przycisków na keyboardzie. Kiedy używamy trybu wskaż i mów, dostajemy dodatkowe komunikaty informujące nas czy urządzenie wykryło naszą rękę oraz dźwięki, które chyba mają pomóc nam naprowadzić palec na tekst. W ustawieniach możemy również zdecydować, czy aplikacja ma czytać tekst pod czy nad naszym palcem. Po wielu próbach kilka razy udało mi się wychwycić skrawki tekstu z urządzeń, jednak z reguły próby kończyły się niepowodzeniem. Nie jestem w stanie ocenić, czy funkcja po prostu nie działa, czy źle trzymam telefon podczas moich prób. Może ta opcja jest stworzona bardziej dla osób słabowidzących, które mogą łatwiej wskazać interesujący tekst, patrząc na ekran.

Mowa na żywo i Indywidualny Głos

Kolejne dwie nowości są ściśle powiązane ze sobą, dlatego omówię je w jednej sekcji. Funkcja “Mowa na Żywo” pozwala nam porozumiewać się ze światem syntezą mowy. Po jej włączeniu, na ekranie pojawi się małe, pływające okienko pozwalające nam wpisywać dowolny tekst lub zapisywać często wypowiadane frazy. Po naciśnięciu klawisza Enter lub wybrania zapisanej frazy zostanie ona odczytana przez syntezator mowy. Jeśli akurat rozmawiamy przez telefon, FaceTime czy inny komunikator, to wpisany tekst będzie wysłany jako głos do naszego rozmówcy. Jeśli nie rozmawiamy przez telefon, to wpisany tekst zostanie odtworzony przez głośnik naszego telefonu czy iPada. Chociaż funkcja nie jest stricte stworzona dla osób niewidomych, to i tak może czasem być przydatna — zwłaszcza dla osób głucho niewidomych korzystających z brajla lub w sytuacjach, w których prowadzimy rozmowę, ale nie możemy lub nie chcemy mówić na głos.

Funkcja Mowa na Żywo może skorzystać z każdego głosu zainstalowanego na urządzeniu — zarówno tych wbudowanych, jak i syntezatorów od firm trzecich. Ale skoro funkcja ma mówić za nas, czy nie byłoby fajnie, gdyby urządzenie przemówiło naszym głosem? Dzięki funkcji “Indywidualny Głos” jest to możliwe.

Jak na razie, spersonalizowany głos możemy stworzyć wyłącznie dla języka angielskiego. Sama procedura jest banalnie prosta i polega na nagraniu około 15 minut naszego głosu. Po rozpoczęciu procesu tworzenia indywidualnego głosu system najpierw sprawdzi, czy mamy odpowiednie warunki do nagrywania (czy nie ma za dużo hałasu, czy nas dobrze słychać ITD.) Następnie będziemy otrzymywać zdania, które musimy przeczytać do mikrofonu. Cały proces jest bardzo prosty i w pełni dostępny z VoiceOverem. Kiedy nagramy wszystkie zdania, rozpocznie się proces tworzenia głosu. Podczas jego trwania, urządzenie musi być zablokowane i podłączone do ładowania. Jeśli odblokujemy ekran lub odłączymy ładowarkę, to proces jest wstrzymywany do momentu, kiedy ponownie podłączymy zasilanie i zablokujemy ekran. Wygenerowanie głosu może potrwać kilka godzin. Muszę przyznać, że rezultat jest naprawdę imponujący. Chociaż słychać, że głos jest sztucznie generowany, to biorąc pod uwagę, że cały proces jest wykonywany w pełni na naszym telefonie czy komputerze, głos jest odwzorowany bardzo dobrze. Stworzony w taki sposób głos możemy udostępnić pozostałym naszym urządzeniom zalogowanym do naszego Apple ID. Domyślnie indywidualne głosy są dostępne wyłącznie w funkcji mowy na żywo (a więc nie możemy ich użyć NP. Z voiceOverem), jednak programiści mogą zaktualizować swoje aplikacje tak, aby uzyskać dostęp do indywidualnych głosów za naszą zgodą.

Dostęp wspomagany

Kolejna nowość została stworzona z myślą o osobach, dla których standardowy interfejs iPhone’a jest trudny do obsłużenia. Dostęp wspomagany pozwala nam zastąpić standardowy ekran początkowy i aplikacje alternatywnymi, uproszczonymi wersjami. I tak na przykład na ekranie blokady będziemy widzieć wyłącznie datę i godzinę, a po odblokowaniu telefonu zobaczymy tylko jedną stronę z ikonami do telefonu, wiadomości czy aparatu. Dostępne w tym trybie aplikacje możemy dostosować przed jego aktywacją, przy czym lista dostępnych aplikacji jest podzielona na te, które zostały przystosowane do dostępu wspomaganego i pozostałe, które będą wyświetlać się tak jak zawsze. Oprócz samych aplikacji możemy dostosować, co ma w nich być dostępne. I tak NP. Dla telefonu możemy ustawić ulubione kontakty, korę wyświetlą się po otwarciu aplikacji oraz czy ma być dostępna klawiatura numeryczna do wybierania dowolnego numeru. Analogicznie w aplikacji wiadomości możemy ustalić skróty do ulubionych kontaktów oraz jakie metody odpowiadania mają być dostępne (klawiatura, rysowanie, Emoji ITD.) Wszystkie te ustawienia, jak i możliwość opuszczenia trybu wspomaganego dostępu są zabezpieczone kodem, który musimy ustawić podczas pierwszej konfiguracji.

Jeśli chodzi o dostępność tego trybu, to niestety w tym momencie ma on duże braki. Po aktywowaniu dostępu wspomaganego potrójne naciśnięcie przycisku bocznego służy do otwarcia ekranu ustawień, więc jeśli chcemy korzystać w nim z VoiceOvera to musimy go włączyć przed aktywacją. Uproszczone interfejsy wbudowanych aplikacji mają poważne braki w dostępności, NP. W aplikacji telefon VoiceOver nie widzi klawiatury do wybierania numerów, a w aplikacji wiadomości po otwarciu konwersacji nie widzi pola do napisania nowej wiadomości.

Pozostałe nowości

Na koniec kilka mniejszych zmian wprowadzonych przez Apple w iOS 17, które nie wymagają wielu objaśnień lub mogą być mniej istotne dla użytkowników w Polsce.

- Prędkość głosu Siri może być teraz dostosowana, a więc Siri może w końcu mówić tak samo szybko, jak VoiceOver

- Sterowanie głosowe będzie teraz podpowiadać sugestie wyrazów, które brzmią tak samo, ale mają różną pisownię (NP. To, two, too w języku angielskim). Sterowanie głosowe otrzymało również nowy samouczek.

- Użytkownicy sterowania przełącznikami mogą teraz skonfigurować je tak, aby symulowały kontroler do gier.

- Dodano globalną opcję pozwalającą na zatrzymanie wszystkich szybko zmieniających się animacji w Safari, wiadomościach czy innych aplikacjach.

Mac OS 14 Sonoma

Mac OS 14 pozwala teraz dodawać do biurka widgety (w tym te, które mamy na naszym telefonie!) Oprócz tego, podczas udostępniania ekranu możemy wyświetlić również naszą twarz obok wyświetlanej aplikacji, żeby łatwiej coś pokazać. Safari pozwala nam teraz zamienić dowolną stronę w aplikacje, którą możemy potem mieć w Docku, zapisaną pod skrótem klawiszowym lub otwartą nawet wtedy, kiedy Safari jest zamknięte.

Wiele z nowości dotyczących sfery dostępności, które opisywałem wyżej, trafiło również do systemu Mac OS. I tak NP. Mowa na żywo oraz możliwość stworzenia indywidualnego głosu pojawiła się także na Macu. Możemy również dostosować dodatkowe parametry syntezatorów w VoiceOverze. Oprócz tego, osoby korzystające z aparatów słuchowych Made for iPhone mogą podłączyć je również do Maca. Apple dodało również łatwą możliwość dostosowania rozmiaru tekstu w większości swoich aplikacji, takich jak Poczta, Notatki czy Wiadomości. Oprócz tego VoiceOver otrzymał jeszcze kilka nowości.

Zmiany w szybkiej nawigacji

Dotychczas tryb szybkiej nawigacji, aktywowany naciśnięciem strzałki w lewo i prawo jednocześnie lub skrótem VO-Q, zawierał w sobie dwa typy skrótów. Pierwszym są strzałki, które przy włączonej szybkiej nawigacji sterują kursorem VoiceOver. Pozostałe skróty aktywowały się wyłącznie wtedy, kiedy znajdowaliśmy się w zawartości www, i są to klasyczne skróty przypisane do liter na klawiaturze, pozwalające nam skakać po nagłówkach, łączach i innych kontrolkach.

W Sonomie te dwa zestawy skrótów zostały oddzielone od siebie. Naciśnięcie strzałki lewo+prawo lub VO+Shift+Q przełącza szybką nawigację strzałkami. Natomiast naciśnięcie VO+Q przełącza szybką nawigację literami, która od teraz działa w każdym miejscu. Pozwala nam to NP. Szybko skakać po nagłówkach lub łączach w aplikacjach typu Pages czy Notatki, jednocześnie ciągle mając możliwość poruszania się po liniach czy znakach strzałkami. Rozdzielenie tych funkcji ma swoje korzyści, ale jest to również coś, do czego będziemy musieli się przyzwyczaić zwłaszcza w internecie. Jeśli mamy włączoną nawigacje literami, a chcemy coś wpisać (może to być zarówno pole edycji na stronie, jak i pasek adresu w przeglądarce), to musimy najpierw ręcznie ją wyłączyć skrótem VO+Q.

Co więcej, o stanie obu tych trybów możemy być teraz informowani dźwiękami zamiast mową. Możemy to skonfigurować w narzędziu VoiceOver.

Kontekstowe czynności

Czynności pozwalają nam zmienić ustawienia VoiceOvera dla konkretnych aplikacji czy stron internetowych. W Mac OS 14 oprócz przypisania czynności do konkretnych aplikacji i stron internetowych możemy je również aktywować w danych kontekstach. Są to M. In. Czytanie kodu źródłowego, edycja tekstu, komunikatory, media społecznościowe ITD. Wydaje się, że opcja ma działać podobnie jak ma to miejsce w iOS — gdzie przypisywanie czynności do kontekstów było dostępne od kilku wersji. W praktyce jedyny kontekst, który u mnie chciał jakkolwiek działać to kod źródłowy, który faktycznie uaktywniał przypisaną do niego czynność, kiedy kursor trafiał do edytora kodu w XCOde. Chociaż na iPhonie kontekst kodu źródłowego uaktywnia się również w innych miejscach (NP. Jeśli na stronie internetowej są fragmenty kodu), to na Macu nie miało to miejsca. Inne czynności chyba próbowały się aktywować w odpowiednim momencie (NP. Czynność przypisana do mediów społecznościowych próbowała się włączyć w aplikacji Mona), ale z jakiegoś powodu natychmiast VoiceOver z powrotem przełączał się na domyślne ustawienia. Funkcja zapowiada się naprawdę obiecująco, ale wymaga dopracowania.

Drobne zmiany w VoiceOver

Kończąc omawianie nowości w MAC OS pozwolę sobie przedstawić kilka mniejszych zmian i poprawek błędów, o których warto wspomnieć.

- Funkcja informowania o wcięciach dźwiękiem teraz działa dużo lepiej. Wiersz jest czytany prawie natychmiast po dźwięku. Możemy również ustawić, ile odstępów ma stanowić jeden poziom wcięcia.

- Możemy przypisać skrót lub gest do szybkiego przełączenia złagodzenia dźwięku. Mała nowość, ale naprawdę cieszy.

- Czytanie plików PDF w aplikacji podgląd zostało znacznie poprawione i jesteśmy w stanie teraz NP. Włączyć czytanie całego dokumentu skrótem VO+A, a VoiceOver automatycznie będzie zmieniać strony podczas czytania. Możemy również szybko skakać po elementach typu nagłówki czy łącza w trybie szybkiej nawigacji, o którym pisałem wyżej. Niektóre pliki PDF nadal nie wyświetlają się poprawnie, ale w większości dokumentów poprawa jest istotna.

- VoiceOver ogólnie reaguje znacznie szybciej niezależnie od syntezatora, z którego korzystamy.

watchOS 10

Dziesiąta wersja systemów dla zegarków Apple jest jedną z większych od jakiegoś czasu, przynajmniej pod kątem wizualnym. Większość wbudowanych aplikacji zostało przebudowane tak, aby lepiej wykorzystywać większe ekrany nowszych zegarków. W większości aplikacji NP. Pogodzie, możemy teraz po prostu przewijać ekran koronką lub gestem dwoma palcami, aby zobaczyć więcej informacji. Podobnie jest z tarczami, które teraz otrzymały przewijającą się pełnoekranową listę widgetów (również dostępną poprzez przewinięcie ekranu w górę lub obrócenie koronki). Z powodu tej zmiany zmienił się sposób, w jaki otwieramy centrum sterowania — jest ono teraz dostępne po naciśnięciu przycisku bocznego zegarka, a dock naszych ulubionych aplikacji znajdziemy po dwukrotnym naciśnięciu koronki. Ponadto watchOS 10 lepiej współpracuje z zewnętrznymi urządzeniami pomiarowymi podczas treningów rowerowych, pozwala monitorować nasze zdrowie psychiczne, wykonywać grupowe rozmowy FaceTime Audio i jeszcze więcej.

Jeśli chodzi o dostępność, to ponownie niektóre funkcje z pozostałych systemów Apple pojawiły się również na zegarku. Sztandarową nowością tutaj jest Mowa na Żywo, która może również korzystać z naszego własnego głosu utworzonego na innym urządzeniu. Zegarek może również dbać o wzrok, monitorując, czy przebywamy odpowiednio długo na słońcu — funkcja ta jest stworzona głównie la rodziców, którzy chcą zadbać o wzrok swoich dzieci.

W VoiceOverze pojawiło się kilka nowych ustawień. W ustawieniach audio możemy teraz wyłączyć złagodzenie dźwięku, co dotąd nie było możliwe. Pojawiło się również ustawienie pozwalające nam zdecydować, czy zegarek ma usypiać, kiedy opuścimy nadgarstek. Wyłączenie tej opcji może być przydatne w sytuacjach, kiedy czytamy dłuższe wiadomości i nie chcemy przez przypadek zablokować ekranu. Na zegarkach pojawił się również syntezator Eloquence, co z pewnością ucieszy jego fanów, chociaż nie otrzymaliśmy tutaj rozszerzonych opcji głosów dostępnych na iOS’ie i Macu.

AirPods

Użytkownicy słuchawek AirPods Pro drugiej generacji, otrzymają kilka przydatnych nowych funkcji, które są dostępne we wszystkich nowych systemach:

- Tryb adaptacyjny — łączy redukcje szumu z trybem kontaktu tak, abyśmy nadal słyszeli wszystko, co istotne, ale jednocześnie redukując szkodliwy hałas.

- Wykrywanie rozmów — automatycznie ścisza odtwarzane multimedia oraz wyłącza aktywną redukcję hałasu, kiedy zaczniemy mówić tak, abyśmy słyszeli drugą osobę. Kiedy przestaniemy mówić, po kilku sekundach system automatycznie powróci do poprzednich ustawień. Co ciekawe, jeśli zaczniemy wykonywać gesty VoiceOvera to stanie się to szybciej.

- Personalizowana głośność — automatycznie dostosowuje głośność słuchawek do tego, czego właśnie słuchamy oraz zewnętrznego hałasu.

Podsumowanie

Kiedy w zeszłym roku opisywałem nowości w systemie iOS 16, napisałem, że zmiany wprowadzone w tamtym czasie nie były rewolucyjne, a bardziej ewolucyjne. W tym roku mógłbym właściwie napisać to samo, chociaż warto zauważyć, że firma Apple nadal eksperymentuje z nowymi technologiami i sztuczną inteligencją. Czasem, jak w przypadku klonowania głosów wychodzi to naprawdę świetnie i to może stanowić rewolucje. Z kolei inne funkcje, jak wskaż i mów obiecują wiele, ale w praktyce wymagają jeszcze dużo pracy. Nie możemy również zapomnieć o Vision Pro — nowym “komputerze przestrzennym” zapowiedzianym przez firmę na czerwcowej konferencji WWDC. Już wiemy, że to urządzenie będzie miało wszystkie funkcje asystujące, w tym VoiceOver. Ten przenośny sprzęt jest naszpikowany czujnikami, takimi jak LIDAR czy kamery 3D, które pozwalają mu w czasie rzeczywistym mapować świat i wykonywać miliony operacji na sekundę. I chociaż developerzy nie będą na początku mieli dostępu do wszystkich tych czujników, to w przyszłości widzę w nim ogromny potencjał. W oparciu o nie może powstać rewolucyjne urządzenie asystujące. Funkcje testowane na iPhone’ach teraz, jak wskaż i mów, nagle mają dużo większy sens, jeśli mamy obie wolne ręce, a odpowiedzialny za nie sprzęt nosimy na głowie — tam, gdzie może widzieć wszystko.

Piotr Machacz